Agility Robotics 解释了如何训练全身控制基础模型

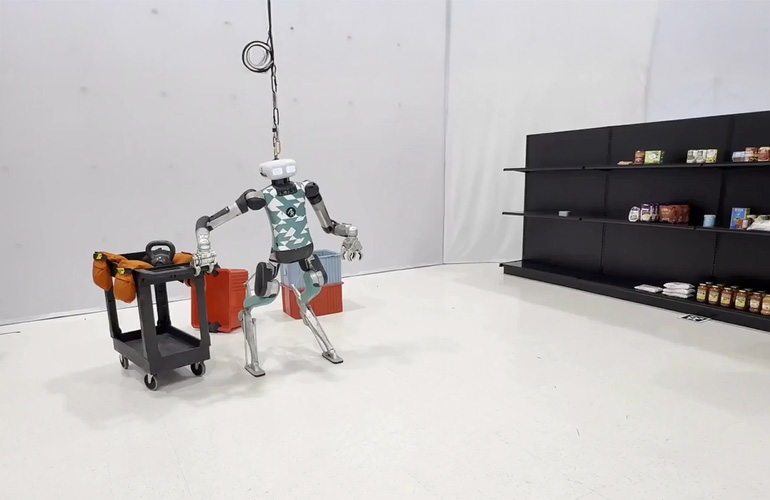

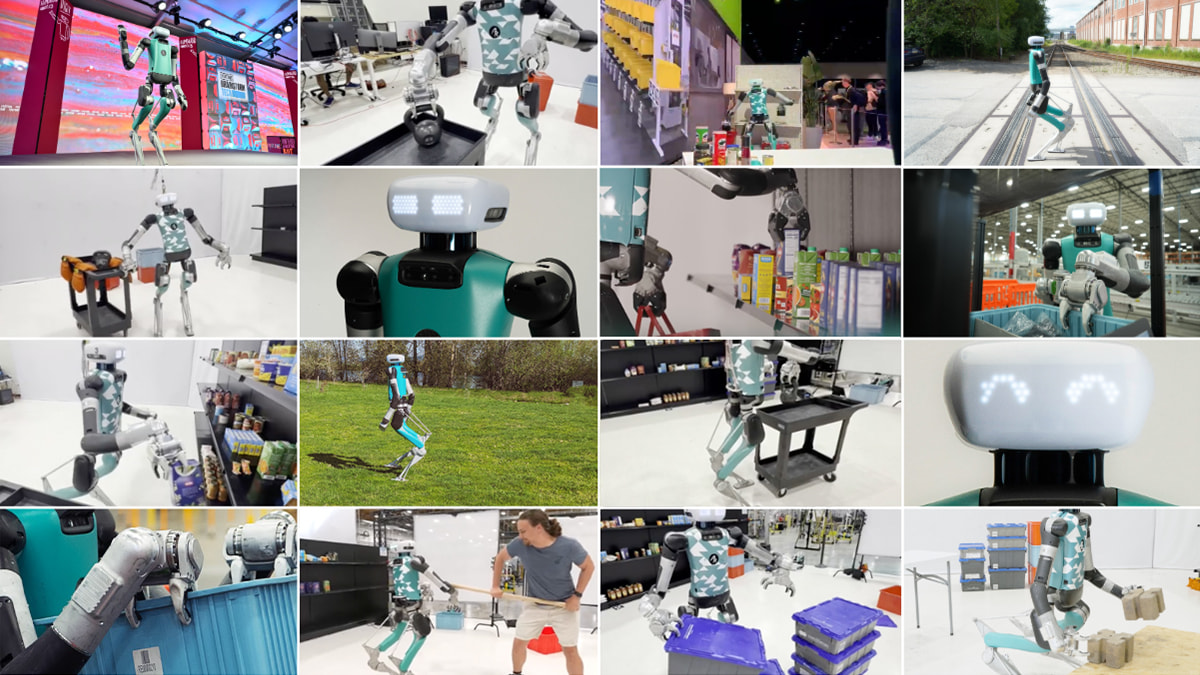

Agility Robotics 为其 Digit 仿人型机器人开发了一个全身控制基础模型。来源:Agility Robotics

根据最近 Agility Robotics 的博客文章,仿人型机器人最显著的优势是能够在高度受限的环境中执行各种任务。建成世界是为人而设计的,能够匹配我们一般能力的机器将是最有价值的。

当然,这并不意味着仿人型机器人必须长得和我们一样,公司之前已经解释过了。

任务目标相对明确,但执行工作却面临各种挑战。机器人必须保持平衡,平稳移动,并对外部环境干扰具有鲁棒性,同时还要以极高的精度进行抓取、握持和操作。最重要的是,机器人绝不能摔倒。

Agility Robotics 为 Digit 赋予了“运动皮层”

为此,Agility Robotics 为其 Digit 人类机器人开发了一个全身控制基础模型,以确保其在执行各种任务时保持安全和稳定。它就像人类大脑中的运动皮层一样,接收来自大脑不同部分的信号——在 Digit 的情况下,是 Agility 的控制层次结构的不同级别——以控制自主运动和精细运动技能。

该模型是一个相对较小的 LSTM(长短期记忆)神经网络,参数少于 100 万个,在 NVIDIA 的 Isaac Sim 物理 模拟器 中进行了训练,模拟时间长达数十年,训练时间为三到四天。

Digit 的运动皮层完全在模拟中学习,并且可以零样本迁移到现实世界。它可以被提示使用手臂和躯干的密集自由空间位置和方向目标来实现不同的目标,包括行走和拾取和放置重物。它可以在运动皮层之上学习下游灵巧操作技能,并且类似地使用大型语言模型(LLMs)协调复杂行为。

Agility Robotics 可以使用多种方法提示其模型,以完成一系列多样化的任务。

三月份,该公司在其早期版本的工作中,在 NVIDIA 的 GTC 活动上展示了 Digit 购物。在这个演示中,策略是由一个开放词汇对象检测器提示的,然后被提升到 3D,执行通过状态机规划循环管理:

Digit 在 NVIDIA GTC 上展示了杂货处理能力。来源:Agility Robotics

Agility 表示,这是使 Digit 在执行复杂操作计划时更加抗干扰的重要一步。该公司还使用 Gemini 研究预览提示了运动皮层:

该控制器也能稳健地拿起非常重的物体:

来源:Agility Robotics

为什么这很难?

Agility Robotics 表示,为了执行有用的工作,机器人必须能够在其末端执行器在世界中稳健地定位和移动。对于固定基座机器人来说,这是一个已经得到充分理解的问题;几十年来,人们已经广泛使用基于模型的算法,如逆运动学(IK)或逆动力学(ID)的简单控制器,取得了极大的成效。

从使用这种系统的用户的角度来看,他们只需要提供末端执行器的期望姿态,固定基座机器人就会迅速移动以匹配该目标姿态。

Agility 表示希望为仿人机器人创建相同的接口:机器人只需通过其末端执行器的期望运动即可获得信息,然后机器人快速高效地定位自身以实现这些目标。

不幸的是,这种能力在腿式机器人上并不简单,它表示。腿式行走的物理特性有两种模式:一种是腿在空中自由摆动,另一种是腿着地并对机器人的其余部分施加力。这两种物理特性由“接触”或“断开接触”的概念分开,这发生在机器人放置脚或抬起脚离开地面时。

这种复杂性带来了巨大的计算成本,为了简化控制和规划问题,几乎总是采用简化假设。一种常见的简化假设是,在末端执行器达到目标或操纵世界中的物体时,机器人的腿将保持与地面的接触——实际上将腿式平台变成固定基座平台。

Agility Robotics 表示,这是一个强大的启发式方法,是机器人领域最近许多令人印象深刻的进步的基础,但也是一个限制现代机器人性能的基本限制。防止机器人动态调整其脚部位置将限制其操作工作空间,并阻止其智能自然地应对工作过程中可能遇到的干扰力。

更理想的界面应该是机器人简单地跟踪用户期望的手部动作,在必要时自行行走,避免与环境的碰撞,并努力不摔倒。在实时生成动态可行的全身运动计划方面的难度,使这种界面对于人形机器人来说,直到最近一直是不可能实现的。

进入强化学习

深度强化学习(RL)正迅速成为人形机器人的主导控制范式。它不是在控制器中显式地模拟机器人混合动力学的运动方程,也不是对整个系统的接触状态做出简化假设,而是在物理模拟器中训练一个神经网络,使其作为控制器来跟踪全身运动,然后将该神经网络部署在硬件上。

最近关于人形全身控制的研究成果令人印象深刻,具有高度动态性,并且与使用更传统的基于模型的控制方法相比,在硬件上实现工作所需的专业知识和精力要少得多。然而,这些研究大多集中在动态全身运动上,如舞蹈,而未能实现移动操作所需的精确跟踪。

Agility Robotics 正专注于双手和双脚施加力的能力,以便 Digit 能够抬起和移动重物。

控制器必须覆盖工作空间

大多数现有的使用强化学习(如 GMT 或 TWIST)训练人形机器人全身控制器的工作都使用大型离线数据集,例如 AMASS 或 LAFAN1 来训练全身控制网络。这已经取得了一些非常令人印象深刻和逼真的结果,但这些轨迹分布通常无法覆盖整个所需的手部操作空间,Agility Robotics 观察到。

不可避免地,这些离线数据集中的手部姿态目标将密集覆盖工作空间中的一些代表性区域,而工作空间的极端区域或其他关键区域则分布稀疏。然而,Agility 坚持认为,手部目标的训练分布必须均匀覆盖整个工作空间,以确保机器人能够可靠地执行利用其整个范围进行复杂操作。

为了确保其运动皮层能够以高精度和可靠性到达工作空间中的任何一点,Agility 采用了一种随机采样方案,我们从工作空间中均匀地随机选择位置和方向,并在这些点之间生成随机的平移和旋转运动速度,为双手和躯干创建时间索引轨迹。它使用一个考虑当前手部姿态和目标手部姿态之间平移和旋转误差的奖励项来训练其运动皮层,以到达这些点。

Agility Robotics 正在用全身控制器模型训练 Digit。来源:Agility Robotics

位置 > 速度

为了训练一个能够以多种方式精确与世界交互的强化学习策略,Agility Robotics 表示希望机器人能够走到世界中的特定位置并停留在那里。

然而,将强化学习应用于双足机器人的大多数文献都训练神经网络来跟踪目标根速度(“匹配这个速度和方向”)而不是根位置(“到达这个点”),例如基于速度的 VMP、AMOR、FALCON、ExBody 和 ExBody2、HumanPlus、GMT、R2S2、MHC 与位置能力型 CLONE、OmniH2O 和 HOVER。

训练控制器以跟踪速度而不是位置,目的是为了移动,这提供了一个更丰富和更宽容的奖励信号,因此通常是一个务实的选择,Agility 表示。此外,在测试时在硬件上跟踪根位置需要(非平凡地)某种形式的里程计,例如一个浮点基础姿态估计器的实现。

然而,一个基于目标速度而非目标位置的移动控制器需要更高级别的规划器对象或人类远程操作员来提供持续的指导,以纠正位置漂移或考虑位置误差。理想情况下,用户会告诉控制器它应该在自由空间中的位置,它会导航到那里,即使被推搡或受到其他干扰,也会自然地返回到该位置。

在任务空间中进行提示比在配置空间中更好

另一个问题是,在先前的工作中,上肢目标设定点通常在关节空间中参数化。这意味着,要实际使用全身控制器,您需要要么配备动作捕捉服,并从人类配置空间映射到机器人配置空间,要么需要一个规划器或模型来生成上肢运动计划,Agility Robotics 表示。

它指出,这些是严重的限制,因为它们要求高级规划层、人类远程操作员或 LLM 需要拥有机器人运动学状态模型。如果控制器基于的是自由空间位置和方向,那么对于下游脚本、 远程操作和行为克隆等构建在控制器之上的应用来说,将更加方便。

这也有助于更接近用于最先进模仿学习方法所使用的表示方式,这意味着我们可以直接使用像 Gemini 这样的模型来预测物体位置,以提供执行策略。

Agility Robotics 层叠行为

Agility Robotics 表示它正在积极建设和部署能够在人类环境中执行有用工作的智能人形机器人。Digit 的“运动皮层”是其中的一部分,该公司表示。它作为一个“始终开启”的安全层,能够实现我们机器人的反应式和直观控制。

“我们可以在这一层运动皮层之上构建复杂的行为,包括学习灵巧的移动操作行为,”它补充道。“我们认为这是朝着为现实世界的人形机器人构建一个安全可靠的运动基础模型的第一步。”

想了解更多关于这个主题的信息,可以查看俄勒冈州立大学动态机器人与人工智能实验室共同主任艾伦·费恩博士的文章:“ 正在兴起的人形运动皮层:RL 训练控制器的清单 。”

关键词: 人形机器人 训练模型 Agility Robotics

加入微信

获取电子行业最新资讯

搜索微信公众号:EEPW

或用微信扫描左侧二维码